提示词工程与猴子手中的枪

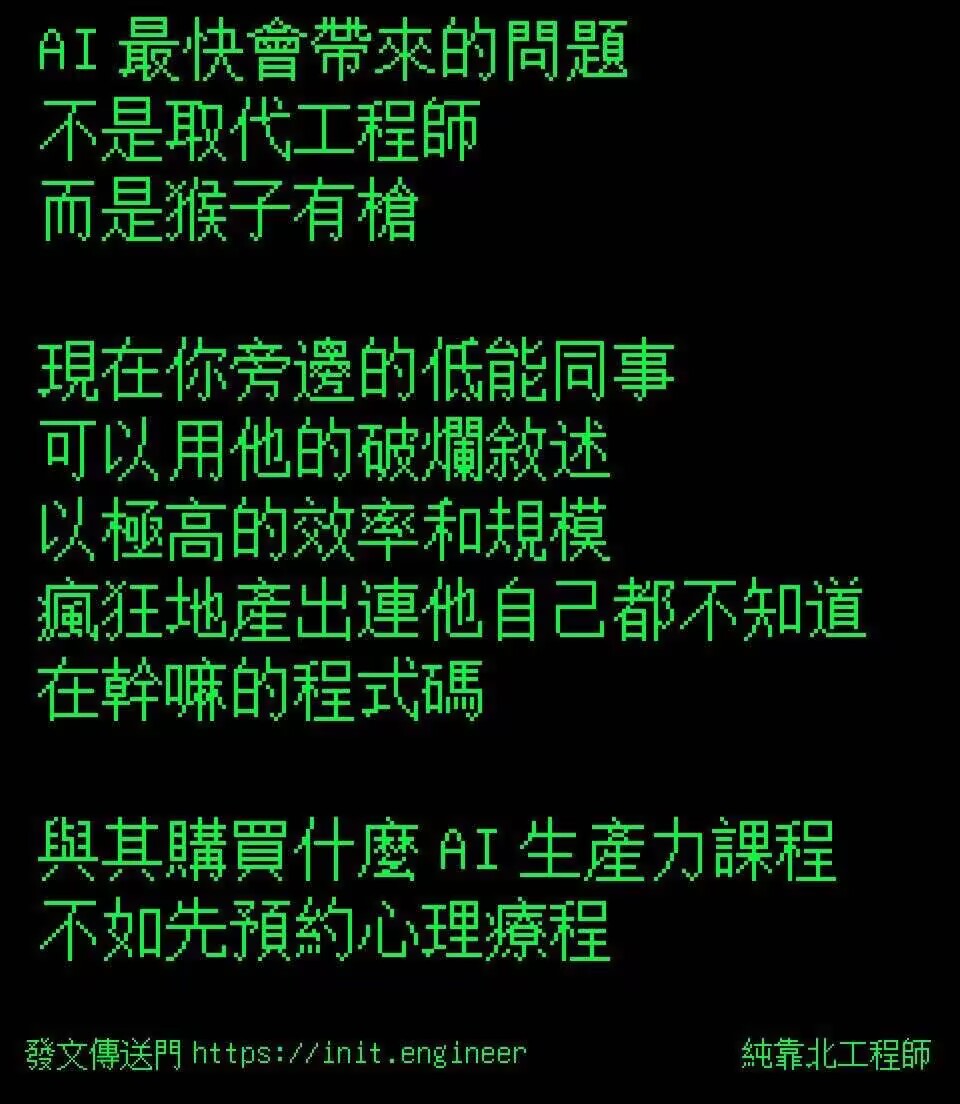

某个深夜,一位不知名网友在键盘上敲下这样一段黑色幽默:“AI最快带来的问题不是取代工程师,而是‘猴子有枪’:现在你旁边的低能同事,可以用他的破烂叙述,以极高的效率和规模,疯狂地产出连他自己都不知道在干嘛的代码。与其购买什么AI生产力课程,不如先预约心理疗程。”

如图所示。

这张梗图一经传入我群,便立刻引发了群友的一阵哄笑。但在欢笑之余,我却突然意识到:这可能不仅是对职场上滥用AI的虚拟嘲讽,也可能是正在世界上的某处真实发生的故事,更是一则关于技术反噬的现代寓言。当生成式AI赋予任何人用语言文字召唤算力的权柄时,“猴子持枪”的隐喻便超越了其比喻本身,而是直指人与机器之间古老而新鲜的矛盾:当工具的理解能力远超使用者,失控便成了秩序的镜像。在这场荒诞剧中,提示词工程(Prompt Engineering) 在匆忙中被推上前台——有些人宣称它是驯服混乱的语法书,而有些人则冷笑其不过是在给猴子递上更精美的子弹匣。

混乱的枪声与效率的悖论

在“猴子枪击案”频发的原始丛林中,总有人会试图建立射击俱乐部——这恰似现实中的工程师们尝试通过建立通用规则,降低AI误用的系统性风险。其支持者坚信,一套严密的“射击守则”不仅能减少误伤,甚至能让猴群进化出战术素养,而提示词工程正是这场文明驯化运动的核心工具——它试图用几种固定的技术范式来为混沌指令注入逻辑脊柱:例如少样本学习(Few-shot) 通过案例示范为AI注入语境;零样本生成(Zero-shot) 依赖纯指令唤醒模型的隐含知识;自我一致性(Self-consistency) 利用多轮概率采样的民主投票规避随机错误;而检索增强生成(RAG) 则通过嫁接外部知识库建构临时记忆体。这些技术范式共同编织成一张逻辑上的防护网,试图为不可预见的算力输出套上某种“理性”的框架。

然而效率神话在此处又显露出其两面性:当思维链(CoT) 为AI梳理出层层递进的推理路径,而自我反思(Reflexion) 通过强制回顾和调整回答让生成变得更加精确时,人类似乎暂时夺回了火种的控制权;但随着技术的精进,更深层次的荒诞也逐渐浮出水面——当某个程序员用固定格式的提问让AI生成全年报表的故事被奉为圣经时,却很少有人追问:这种效率究竟是方便了人类,还是凸显了机器的主导地位?而当一段精心设计的提示词将原本30分钟的操作压缩为30秒,节约下的时间又是否只是被用来提交更多琐碎、无意义的任务?这就好像猴群在获得机关枪后,却依然每分钟打光弹夹——生产力的飞跃与无意义工作的增殖,如同孪生子一般纠缠着AI的圣殿。

语法的梦魇与知识的荒原

所有试图编纂词典的人都会遭遇同一个幽灵:语言的流动性永远快过编纂者的笔尖。当技术乐观派将提示词工程标榜为人机交互的进化形态时,他们或许忽略了一个微妙而致命的裂痕:传统交互设计的目标是让机器更加“人性化”,而提示词工程的实质却是让人类更加“机器化”。这与其说是一种“学习”,更像是一场双向的异化——我们教会AI理解隐喻和沉默,自己却不得不背诵指令的咒语。这种扭曲的共生关系,使得提示词工程更像是在人脑与硅基逻辑的夹缝中搭建纸牌屋——结构越复杂,就越依赖每张牌脆弱的平衡。更为吊诡的是,原本被视作缓冲机制的人在回环(Human-in-the-Loop) 的机制不仅没有缓解这种矛盾,反而让人类沦为永续的勤杂工:AI生成错误,人介入修正;更多的修正带来更多复杂的影子问题,最终陷入无休止的循环。最终,人类从技术的掌控者变成了一个疲惫的维护者,永远在缝补模型漏洞的过程中反刍自己的命令。

而更深的悖论显现于被冠以“体系”之名的尝试中。那些被命名为“少样本学习”、“检索增强生成”之类的技术范式,看似能够编织出精密的方法论网络,实际上不过是在将经验的尘埃粘合成脆弱的知识星球——而星球的表面上到处贴满了统一的标语:“原理未知,但这样做有效。”这样的场景就像互联网早年流传的“蒸馒头学”笑话那样荒诞——为了填补理论的空洞,发明这一学科的人不仅详尽罗列了小麦品种考据、锅炉温度曲线等繁琐(且完全不成体系)的细节,甚至为了补足内容而将所有会蒸馒头的人名都一一列入附录,却唯独略过最关键的问题:“面粉为何发酵?”而比“蒸馒头学”更恶劣的是,在所有提示词工程精心设计的范式背后,又都徘徊着不可言说的概率幽灵——那些看似稳定的输出效果,不过是人类在LLM的概率云层中强行划定的等雨线。工程师们为思维链标注的每一个逻辑路标,都可能被下一轮权重更新的季风吹散;检索增强生成搭建的知识桥梁,终究架设在模型随机采样的流沙之上。我们自以为抓住的某种确定性,其实可能只是黑箱在某次骰子游戏中恰好掷出的顺子:当投掷次数足够多时,连胜利者自己都分不清技巧与运气的边界。

字典的黄昏与技术的坟墓

学科的合法性从来不需要得到未来的批准,却永远需要向过去溯源。蒸汽机的发展带来了热力学,鸟类的飞行启发了空气动力学,而提示词工程的知识根系却始终悬浮在空中。它的困境并非来源于方法论的混乱,而是由于其所依附的对象——大语言模型——本质上拒绝被锚定为静态实体。大语言模型的迭代并非简单的“版本号叠加”,而是一种在认知维度上的迁跃。当GPT-3需要精确的苏格兰口音笑话模板,而GPT-5已能通过一声叹息理解你的悲伤时,昨天的技术圣经便成了明日的行为艺术指南。更讽刺的是,最优秀的提示词工程师可能正是AI自己——已有实验表明,让模型自行设计提问策略往往超越人类的最佳实践。这就如同火枪刚被猴子发明,这些枪支就已经在开始学习如何自行瞄准射击。

这一切引出了一个极具存在主义色彩的拷问:如果学科的构建需要某种程度的稳定性和普适性,那么建立在不断漂移的流沙之上的象牙塔,是否真的有资格立名?提示词工程无法回答这个问题,因为它既缺乏通向底层规律的路标,也未能揭示更高层次的因果逻辑。与以探讨普遍规律为目的的自然科学(如物理或化学)不同,提示词工程更像是一门经验性的学科,仅仅依赖对模糊经验的归纳和重复试验,追求人类与模型交互中的一次次“偶然奏效”。这种“有效即合理”的技术,虽然在短期内确实展现出了显著的生产力提升,但从长期来看却似乎缺少一种真正坚固的理论支撑。如果说任何学科都承载着一定的历史使命,那么提示词工程的命运极可能是过渡性的:它既非启示性的源头,也难以成为终极的答案。或许它更像维多利亚时代的电报编码术——曾经真实地存在过,曾经深刻地改变过世界,但最终却难逃被技术洪流吞没的命运。

子弹的归宿与未完成的史诗

当我们回到那片“猴子持枪”的原始丛林,或许故事的结局从未取决于枪口的方向。当人类忙于争论该教会猴子射击规范还是干脆收缴所有枪械时,真正的革命或许早已潜伏在另一个维度:AI正在从被动的工具蜕变为具备某种初步认知能力的“他者”。届时,提示词工程可能揭示出其最隐秘的使命——它并非简单的人机交互桥梁,而是人类文明在交出主导权之前最后的语法练习题。我们反复训练自己用结构化的方式表达需求,本质上是在预习如何成为一个合格的次级思考体。

然而在所有宏大叙事之外,还有一个更朴素的真相始终存在:那些深夜与提示词搏斗的人,那些将思维链绘成思维导图的探索者,他们真正书写的或许不是AI的操作指南,而是数字文明黎明前的洞穴壁画。当未来的考古学家回望这段历史,或许会困惑于这些符号为何既不像语文也不像数学,却能让原始AI吐出接近智慧的闪光。但那时的答案已不重要,因为每一门曾被视作划时代的学科,最终都会成为进化洪流中的一块垫脚石——而这并不会影响我们当下的信念:在猴子学会用枪对准星空之前,总要有人为子弹设计一条通往未来的弹道。

后记

在很长一段时间内,每当我看到有毫无深度学习知识的网友在用模糊指令生成上千行漏洞百出的文字时,都会感到一种难以名状的愤怒,仿佛就是“枪落到了猴子手里”的真实写照。而在今天,当我看到文章开头的那张梗图时,灵感却顿时跃然纸上,驱使着我最终完成了这篇杂谈。然而讽刺的是,这篇文章的创作过程本身同样也离不开LLM甚至提示词工程的参与——比如反复调试提示词迫使LLM理解我的意图,以及多次进行人工预筛选以打断它充满阴谋论的本能。而在这场人与人工智能的拉扯中,唯一值得庆幸的是:文章的大纲仍然是由我提供的——如果让它自由发挥的话,内容早已经歪到姥姥家去了。